-

Notifications

You must be signed in to change notification settings - Fork 4

Open

Description

Reference

- 机器学习类别不平衡处理之欠采样(undersampling)

- 欠采样(undersampling)和过采样(oversampling)会对模型带来怎样的影响

- 机器学习——下采样(under-sampling)

- 不均衡学习的抽样方法

- package - imbalanced-learn

- Exploratory Under-Sampling for Class-Imbalance Learning

- 关于keras的class_weight与sample_weight(解决样本不均衡或类别不均衡问题)

undersampling

多数据较多的类别丢弃一些样例,使得各类别数据量更平衡

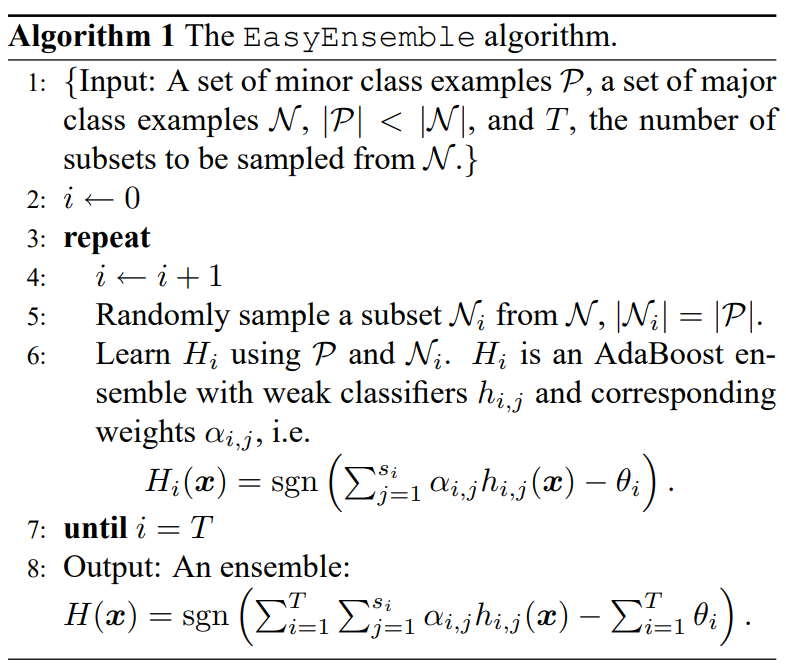

EasyEnsemble - 模型融合

- 把数量较多的类别分成多个子集

- 把子集和数据量较少的类别合成数据集训练多个子模型

- 多个模型集成

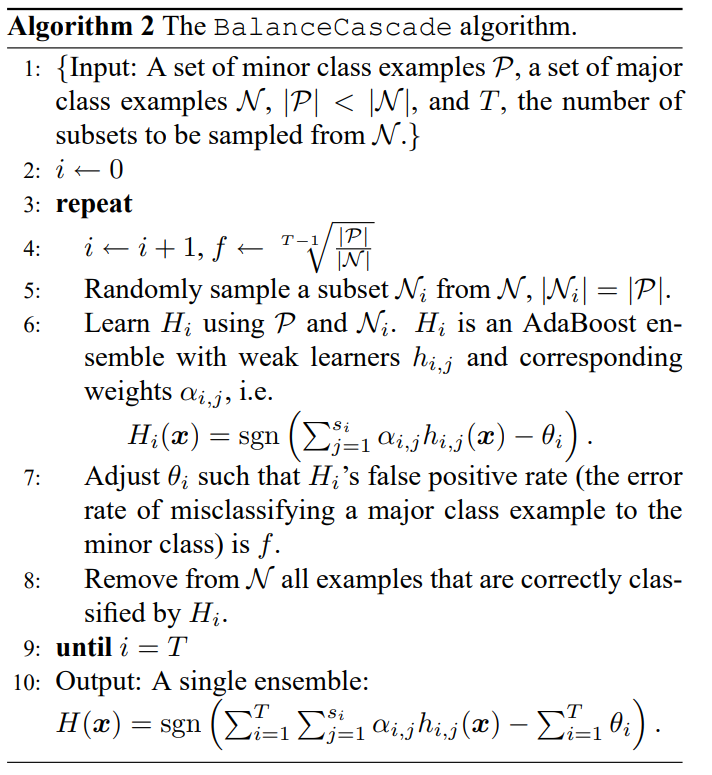

BalanceCascade - 增量训练

- 欠采样数量较多(major)的样本

- 训练一个分类器

- 每次移除分类正确的样本

NearMiss - KNN

- 从多数类样本中选取最具代表性的样本用于训练

- NearMiss-1:选择到最近的K个少数类样本平均距离最近的多数类样本

- NearMiss-2:选择到最远的K个少数类样本平均距离最近的多数类样本

- NearMiss-3:对于每个少数类样本,选择K个最近的多数类样本

- 目的是保证每个少数类样本都被多数类样本包围

ENN - Edited Nearest Neighbor

- 删除那些类别与其最近的三个近邻样本中的两个或两个以上的样本类别不同的样本

NCL - Neighborhod Cleaning Rule

oversampling

重复采样数据较少的类别,使得各类别输入数据量更平衡

- 容易过拟合

SMOTE

Synthetic Minority Oversampling Technique

- 对少数类样本进行分析并根据少数类样本人工合成新样本添加到数据集中

Borderline-SMOTE

ADASYN - Adaptive Synthetic

Metadata

Metadata

Assignees

Labels

No labels