diff --git a/docs/source/ko/using-diffusers/img2img.mdx b/docs/source/ko/using-diffusers/img2img.mdx

new file mode 100644

index 000000000000..764df6a72cf8

--- /dev/null

+++ b/docs/source/ko/using-diffusers/img2img.mdx

@@ -0,0 +1,100 @@

+

+

+# 텍스트 기반 image-to-image 생성

+

+[[Colab에서 열기]]

+

+[`StableDiffusionImg2ImgPipeline`]을 사용하면 텍스트 프롬프트와 시작 이미지를 전달하여 새 이미지 생성의 조건을 지정할 수 있습니다.

+

+시작하기 전에 필요한 라이브러리가 모두 설치되어 있는지 확인하세요:

+

+```bash

+!pip install diffusers transformers ftfy accelerate

+```

+

+[`nitrosocke/Ghibli-Diffusion`](https://huggingface.co/nitrosocke/Ghibli-Diffusion)과 같은 사전 학습된 stable diffusion 모델로 [`StableDiffusionImg2ImgPipeline`]을 생성하여 시작하세요.

+

+

+```python

+import torch

+import requests

+from PIL import Image

+from io import BytesIO

+from diffusers import StableDiffusionImg2ImgPipeline

+

+device = "cuda"

+pipe = StableDiffusionImg2ImgPipeline.from_pretrained("nitrosocke/Ghibli-Diffusion", torch_dtype=torch.float16).to(

+ device

+)

+```

+

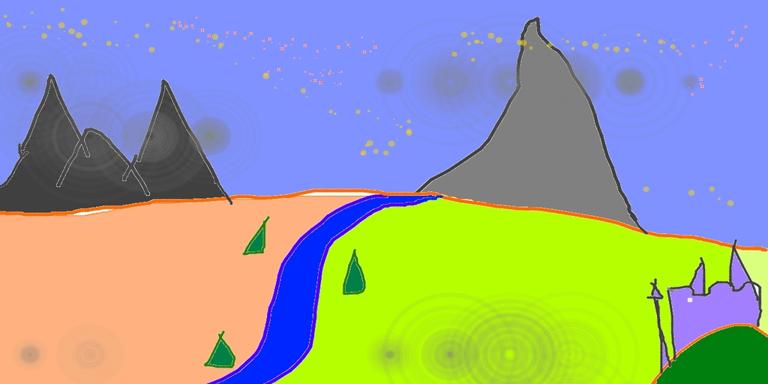

+초기 이미지를 다운로드하고 사전 처리하여 파이프라인에 전달할 수 있습니다:

+

+```python

+url = "https://raw.githubusercontent.com/CompVis/stable-diffusion/main/assets/stable-samples/img2img/sketch-mountains-input.jpg"

+

+response = requests.get(url)

+init_image = Image.open(BytesIO(response.content)).convert("RGB")

+init_image.thumbnail((768, 768))

+init_image

+```

+

+

+

+

+

+

+

+

+

+ +

+ +

+ +

+